文|周鑫雨

編輯|蘇建勛

「零一萬物絕不放棄預訓練。」

2024年10月16日,AI獨角獸零一萬物創始人兼CEO李開復,公開立了軍令狀。也在同一天,零一萬物發布了最新的MoE(混合專家)架構的旗艦大模型:Yi-Lightning。

這也是時隔5個月後,零一萬物再次更新模型的新動態。

李開復表示,Yi-Lightning的訓練只用了2000張GPU,訓練周期僅一個半月,成本只有300多萬美元,是埃隆·馬斯克的xAI成本的1%、2%。

訓練成本雖然低,但Yi-Lightning的性能並沒有打折扣。在加州大學伯克利分校LMSYS團隊的Chatbot Arena(聊天機器人競技場)總榜單上,Yi-Lightning的性能與xAI的Grok-2-08-13模型並列第6,並且超越了OpenAI的GPT-4o-2024-05-13。

LMSYS團隊的Chatbot Arena(聊天機器人競技場)大語言模型綜合能力總榜單。圖源:零一萬物

值得注意的是,在中文能力上,Yi-Lightning與OpenAI的最新模型o1-mini版本並列取得了第二;在數學能力上,Yi-Lightning和Gemini-1.5-Pro-002並列第3,僅次於在數學、邏輯推理見長的o1。

在定價上,Yi-Lightning也創了零一萬物模型的最低定價:0.99元/百萬Token。

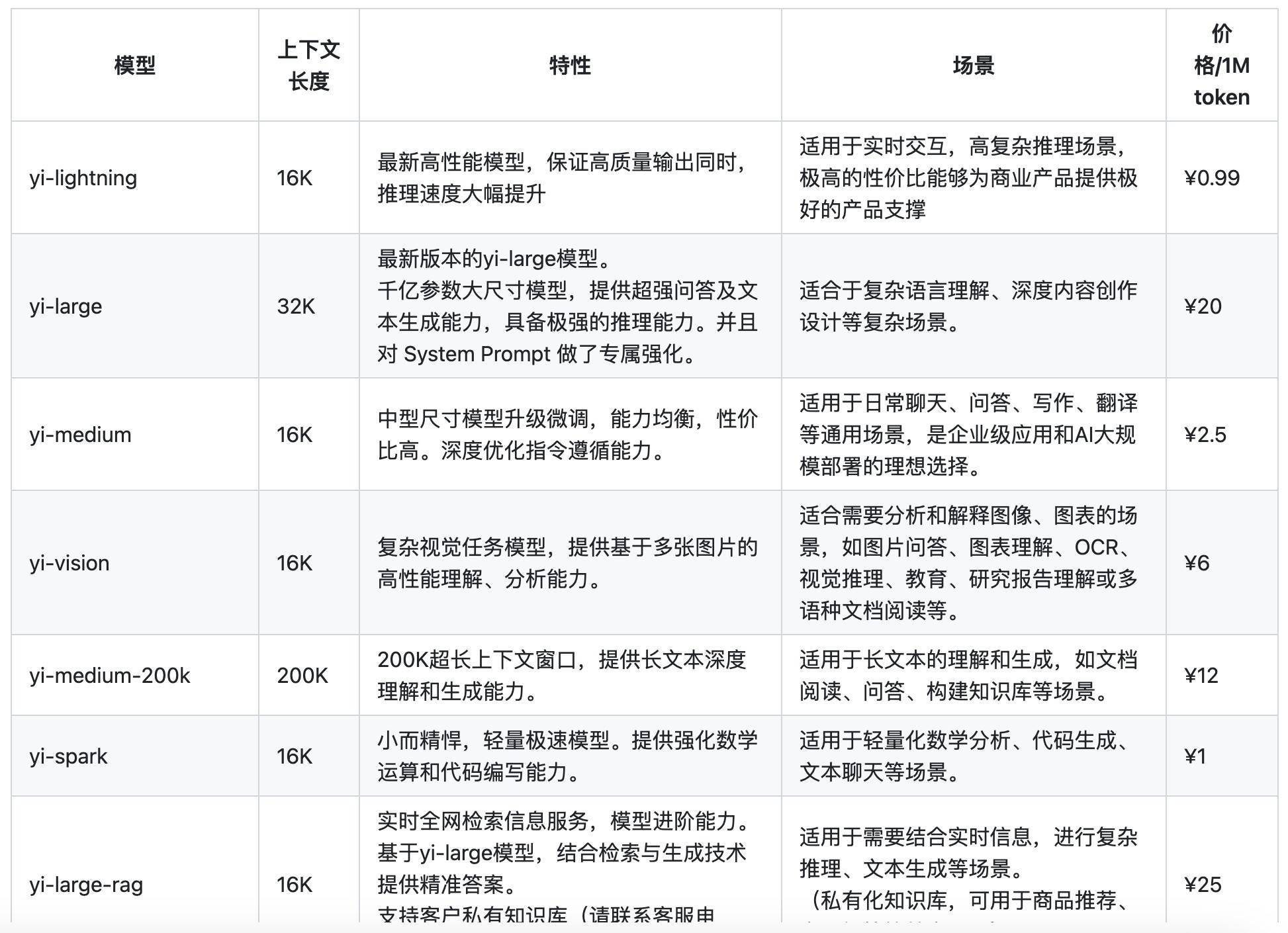

零一萬物模型定價。圖源:零一萬物官網

當然,榜單排名並不意味著模型在任務場景下的能力。在發布會上,零一萬物著重在實用性上,讓Yi-Lightining秀了一把肌肉。

比如,Yi-Lightining相比2024年5月發布的Yi-Large,首包時間(從接收到任務請求到系統開始輸出響應結果之間的時間)縮短了一半,最高生成速度提升了近四倍。

具體到翻譯場景,Yi-Lightining比豆包、DeepSeek、通義千問最新旗艦模型的翻譯速度更快,且翻譯結果更加信達雅。

四個模型在相同翻譯任務上的表現。圖源:零一萬物

發布會上,李開復也揭秘了Yi-Lightning的訓練策略:

- 獨特的混合注意力機制(Hybrid Attention):在處理長序列數據的過程中,能夠提高性能的同時,還能降低推理成本;

- 動態Top-P路由機制:根據任務難度自動選擇最合適的專家網絡組合;

- 多階段訓練(Multi-stage Training):讓模型在不同階段吸收不同的知識,方便mixing團隊進行數據配比的調試工作,並能保證不同階段的訓練速度和穩定性。

在2024年5月份的發布會上,零一萬物在國內發布了C端的生產力產品「萬知」。時隔五個月,零一萬物的B端商業化版圖也有了新的進展——聚焦零售和電商等場景的AI 2.0數字人。

AI 2.0數字人的背後,是電商話術大模型、角色大模型、直播聲音大模型的多模態協同訓練。目前,AI 2.0數字人還接入了Yi-Lightning。用戶只需要輸入出售的商品、聲音的性別和語調,就能生成相應的數字人。

零一萬物AI 2.0數字人接入Yi-Lightning前後對比。圖源:零一萬物

如今,大模型發展也來到了技術探索的深水區。即便立下了「絕不放棄預訓練」的軍令狀,李開復也承認:「但不是每家公司都可以做這件事情,做這件事情的成本也比較高,以後有可能會越來越少的大模型公司訓練做預訓練。」

不過,對如今六家大模型獨角獸,李開復依然抱有樂觀的態度:

「據我所知,這六家公司融資額度都是夠的,我們做預訓練的production run,訓練一次三四百萬美金,這個錢也是頭部公司都付得起,我覺得中國的六家大模型公司只要有夠好的人才,想做預訓練的決心,融資額跟晶片都不會是問題的。」

歡迎交流!