NeurIPS’20大意了没有闪,被一句话超短摘要偷袭1900篇论文!

作者 | 陈大鑫

刚才,有两个年轻人问我,陈老师,发生肾摸事了?

我说肿么了?

塔焖啪的一下发来了一张截图,很快噢!

嗷!源赖氏佐田,有两个AI人,一个24岁,一个29岁,一个发过4篇顶会,一个发过9篇顶会。

塔焖问我 NeurIPS 2020还两个星期就要召开啦,可是收录的1900篇论文, 塔焖怎么读都读不完了~

我说这个问题嫩们算是问“对”人了,因为陈老师我 作为浑元形意AI掌门人亿篇顶会都没发过,但是我之前已经“教”过大家了:

AI科技评论给大家提供了两个NeurIPS 2020论文阅读的便利。

1、阅读大牛的论文:

见“NeurIPS 2020论文接收大排行!谷歌169篇第一、斯坦福第二、清华国内第一 ”一文。

在这篇文章中,AI科技评论列举了AI学术大牛如深度学习三巨头、周志华、李飞飞等人的论文,大牛的团队出品的论文,质量平均而言肯定有很大保证的。

2、按主题分门别类的阅读:

这是显而易见的选择,也是大家正在做的事情,AI科技为此也为大家整理了一份超详细的分门别类指南,见NeurIPS 今年共收录1900篇论文,我该怎么阅读? 一文。

他们说我这个不行,我说我这个行,他们说他们甚至懒得读论文的摘要,我说好吧,那嫩们要不要试试看我的闪电阅读法:

好吧,闪电阅读法可能有些难学,今天陈老师给大家介绍一个刷 NeurIPS论文列表的神器,帮助大家高效地有选择性的阅读。

这就是Paper Digest团队给大家提供的 “One sentence highlight for every

NeurIPS-2020 Paper”, 又名为: Paper Digest: NeurIPS 2020 Highlights

网址:https://www.paperdigest.org/2020/11/neurips-2020-highlights/

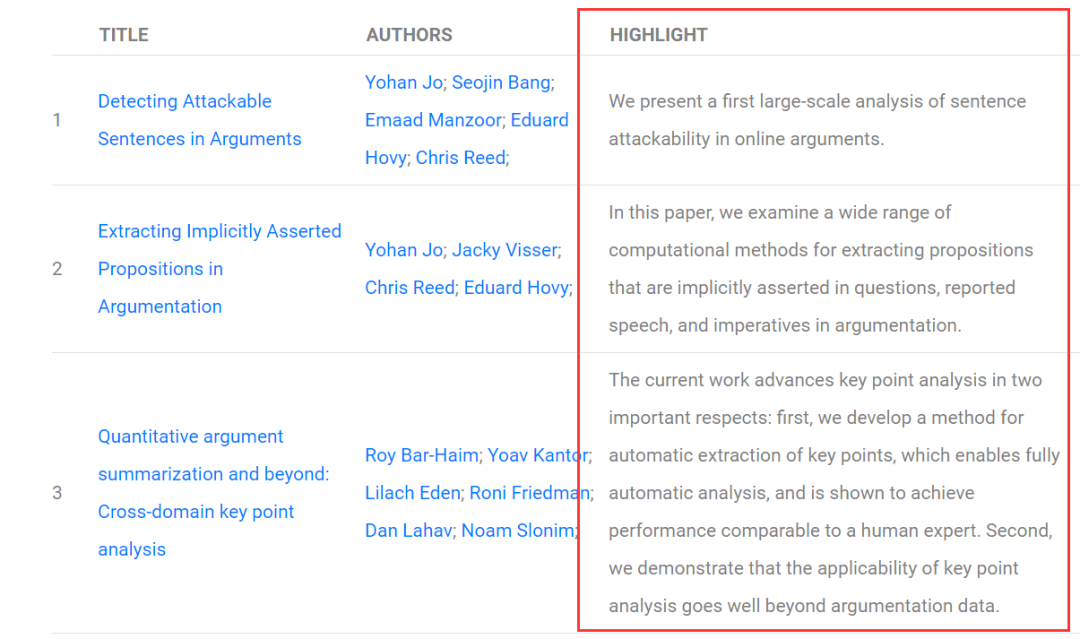

在这个网站上,他们用AI为每一篇论文自动生成一句话超短摘要(Highlight),以此帮助大家更快地了解到每篇论文的最核心的idea和贡献,从而更快筛选出自己感兴趣的论文。

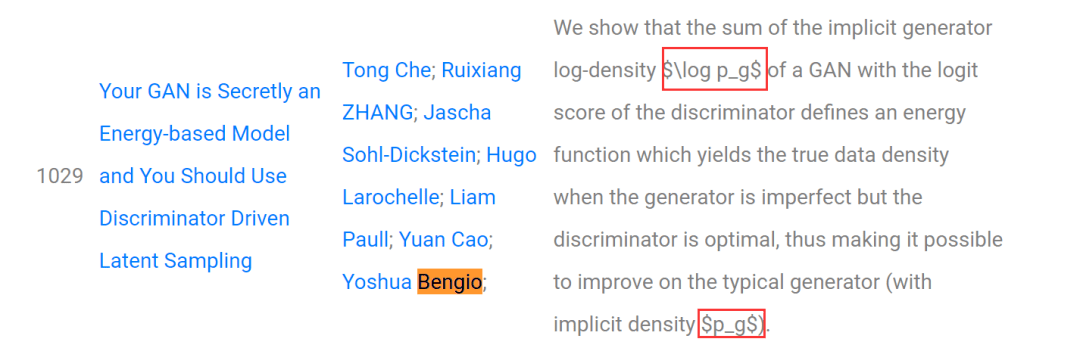

图中 Highlight一列就是每篇文章的重点:

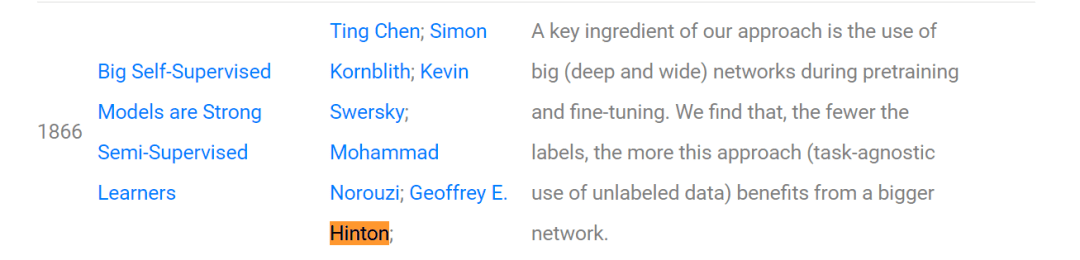

我们不妨来看一下这个网站对Hinton团队在NeurIPS 2020上发表的论文《Big Self-Supervised Models are Strong Semi-Supervised Learners》生成了什么样的摘要:

A key ingredient of our approach is the use of big (deep and wide) networks during pretraining and fine-tuning. We find that, the fewer the labels, the more this approach (task-agnostic use of unlabeled data) benefits from a bigger network.

翻译下来大概是:

我们方法的一个关键因素是在预训练和微调期间使用大(深和宽)网络。我们发现,标签越少,这种方法(对未标记数据的任务无关性使用)从更大的网络中获益越多。

而碰巧的是AI科技评论前些天写了一篇文章对Hinton团队这篇论文做了介绍:Hinton新作!越大的自监督模型,半监督学习需要的标签越少 , 大家可以评判一下这个AI生成的摘要效果到底如何?

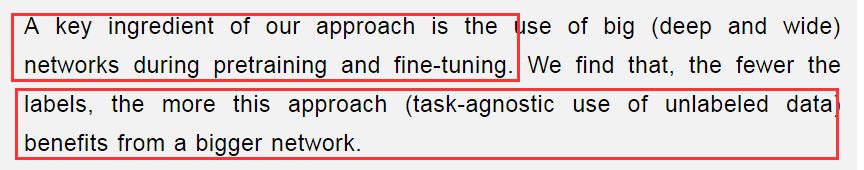

另外有眼尖心细的朋友发现了:陈老师,这并不是一句话摘要吧?上面明明是两句话好吧?

话落,又给我发了张截图:

我啪的一下就站起来了!看来是有Bear而来啊......

AI不讲武德,说好的一句话怎么变成两句了呢?......

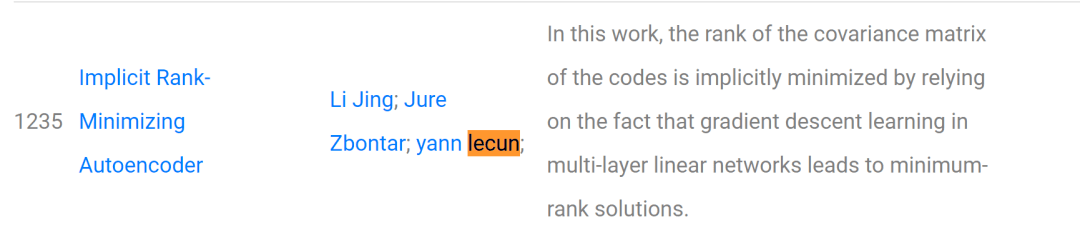

我接着又放出了Lecun团队论文的一句话摘要:

In this work, the rank of the covariance matrix of the codes is implicitly minimized by relying on the fact that gradient descent learning in multi-layer linear networks leads to minimum-rank solutions.

我说嫩们看看!这是不是只有一句话?

本文利用多层线性网络中的梯度下降学习导致最小秩解的事实,隐式地最小化了码的协方差矩阵的秩。

这时,来了一位200多斤的“大理石”,他说他找到了Bengio老师论文的一句话摘要:

他问我$log p_g$是什么意思?他说这不行,妨碍他阅读了。

我说婷婷!年轻人不要太较真,这好吗?这不好,你这样还怎么让AI去“骗”,去偷袭1900篇的老论文......

再说这是小学二年级就该学过的指数表达符号啊:

这是问题吗?这不是...

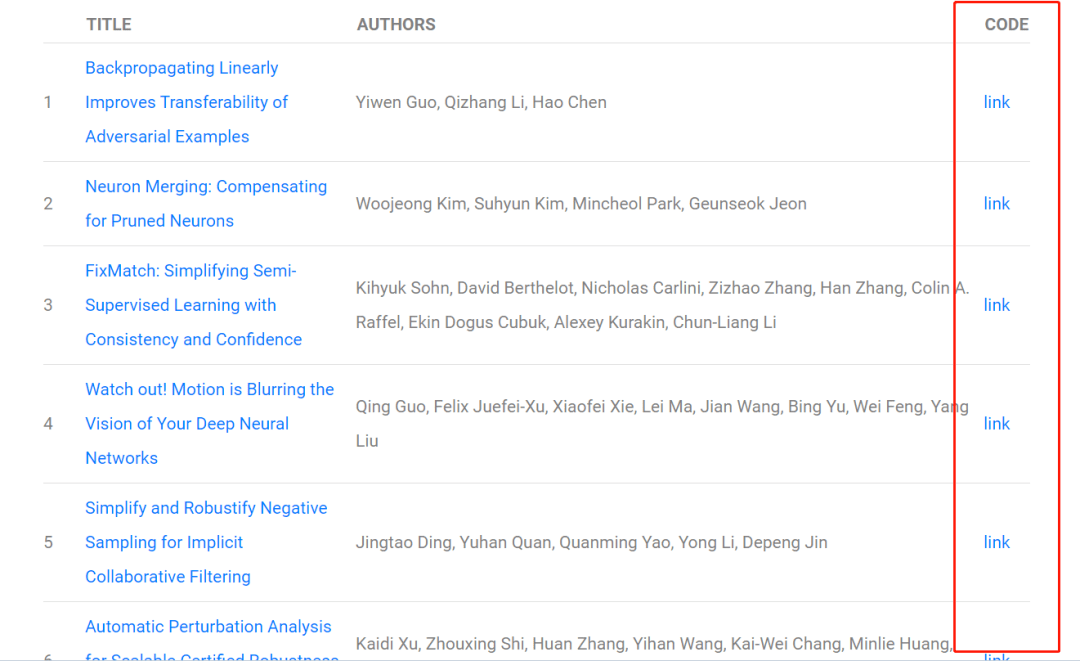

最后,除了一句话摘要外,本网站还能查到有150多篇已经有开源代码/数据集的论文:

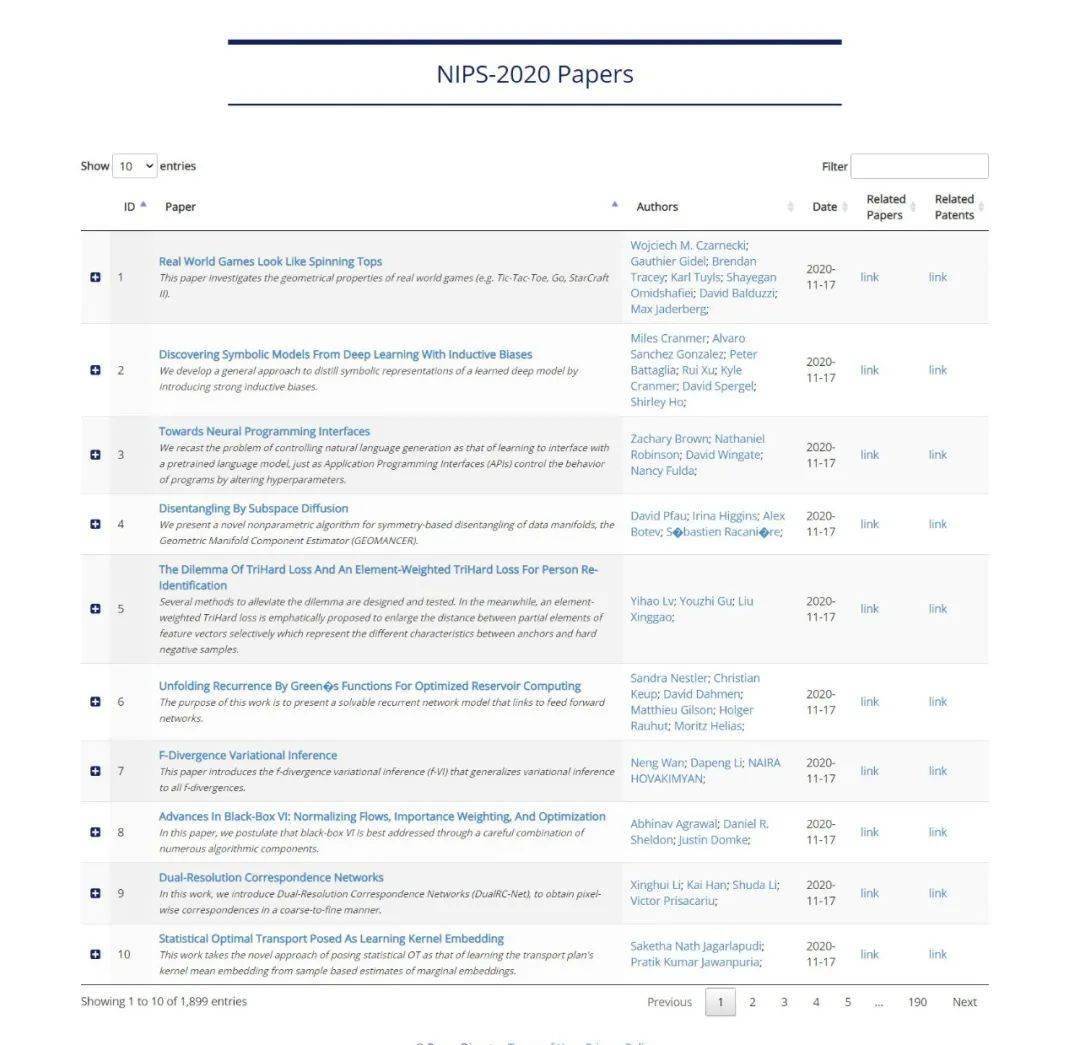

而以下网站则是以每页十篇论文的方式更为方便地为大家展示了论文。

https://www.paperdigest.org/topic/?topic=nips&year=2020

1900篇论文,我劝各位AI人耗子尾汁,好好反思,以后不要再犯这样的聪明,小聪明…......

爱(AI)要以和为贵,要讲武德,不要只讲数量,要讲质量!

不要搞窝里斗,不要内卷,谢谢朋友们!

参考“文献”:

https://www.paperdigest.org/2020/11/neurips-2020-highlights/

https://www.paperdigest.org/2020/11/neurips-2020-papers-with-code-data/