10月11日上午,在備受期待的科技春晚----特斯拉「We Robot」發布會上,馬斯克向世界展示了特斯拉在自動駕駛和人工智慧領域的最新成果:Cybercab、Robovan和Tesla Bot。

Cybercab其實就是無人駕駛計程車,Robovan是無人駕駛公交車,而Tesla Bot就是特斯拉的人形機器人,會走會跑會跳舞。

值得一提的是,這三款新產品,用的都是特斯拉一直所推崇的FSD路線,按照馬斯克的說法,這三款產品,意味著人類智能駕駛時代的到來。

很多人都奇怪,中國的蘿蔔快跑無人計程車都已經上路一年了,特斯拉這次的無人計程車又有什麼特別之處?特斯拉的這種技術,會應用于軍事嗎?

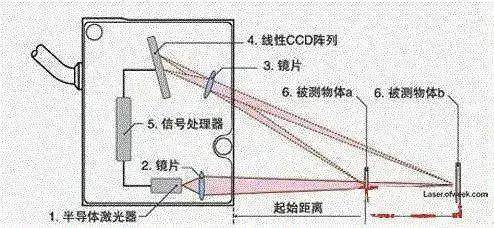

我們都知道,在智駕領域,一直有雷射雷達和純視覺兩條路線。

雷射雷達其實發展很多年了,早在70年代,坦克已經普及了雷射測距機,來測量敵方目標的距離,進而確定火炮諸元。

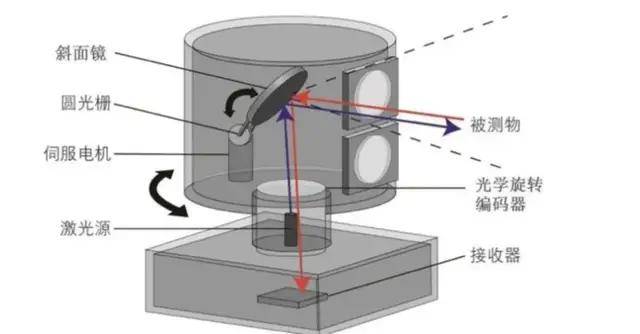

於是就有人腦洞大開了,把發射的雷射線增多,能感知的區域和細節不就越多了麼?那麼通過讓反射的雷射轉動掃描,不就可以得到一片區域的三維形態了麼?

這就是雷射雷達的雛形。

後來,雷射雷達經過發展,已經發展到機械式、半固態和固態三種類型,並廣泛應用於智能駕駛汽車,中國大部分智駕汽車,包括前一陣子火爆的蘿蔔快跑無人計程車,用的就是雷射雷達路線。

不過呢?雷射雷達路線雖好,也是有缺點的。

第一是貴,一顆雷射雷達動輒數千元,新一代蘿蔔快跑已經發展到4顆雷射雷達,再加上其攝像頭、毫米波雷達等等零部件,光傳感器一項,成本就要兩三萬元,大大影響了市場推廣。

第二是依賴算法。簡單來說,雷射雷達只是傳感器,告訴主機路況如何,主機要根據算法做出智駕決策。

這就帶來了一個問題,路上遇上的各種情況,是無窮無盡的,但算法,是有窮盡的。

簡單來說就是,路上總會遇到算法沒有設想到的情況,比如雙車道前面一輛車莫名其妙停下來,而車道中間又是實線,算法往往就會停車不走了,而不是壓實線繞開前車,因為其遵守交通規則的權重是最大的。

所以最近這一年多,我們已經看到了不少智能駕駛(其實現在頂多算是輔助駕駛)的事故了,這裡面有不少是第三方的原因,也有智駕算法應付不了突發情況的原因。

而另一條路線呢?就是特斯拉的FSD,Full-Self Driving,中文名「完全自動駕駛」,2021年,特斯拉正式發布 FSD Beta 版,走的是純視覺方案。

FSD的傳感器,不是雷射雷達,而是攝像頭。

用馬斯克的話來說,「用雷射雷達的都是傻子。」「(雷射雷達)就像是人身上長了一堆闌尾。」

這話說得,好像雷射雷達是落後技術一樣,其實並不是如此。馬斯克摒棄雷射雷達推崇攝像頭,主要原因還是攝像頭便宜,雷射雷達要幾千塊,攝像頭只要幾百塊,對馬斯克這樣造火箭都用不鏽鋼的人來說,降成本是其一直追求的目標。

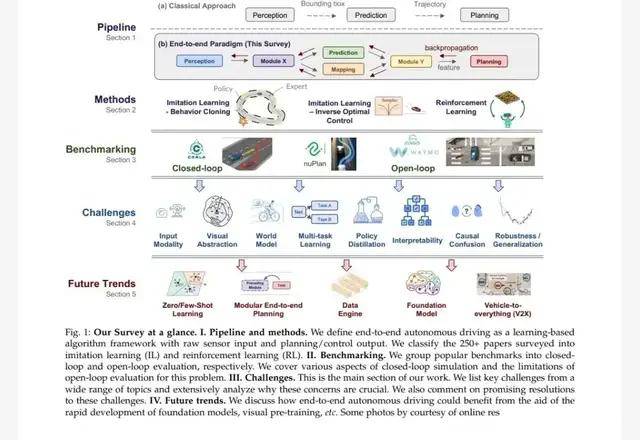

FSD其實一開始的路線和智駕路線沒什麼太大的區別,都是「感知+算法」,先用攝像頭看看前方有什麼,有沒有車,車速多少,方向如何,是紅燈還是綠燈,是實線還是虛線,然後再按照編制好的算法進行決策。

這談不上多先進,所以純視覺方案一開始相比雷射雷達路線並沒有太大優勢,所以特斯拉的智駕事故一點也不少。

但是吧?從2024年春天發布的FSD V12版本開始,情況發生變化了,AI技術應用於FSD之後,FSD實現了脫胎換骨的變化。

特斯拉刪除了30多萬行人工編寫的智駕算法代碼,刪除後FSD V12的C++代碼只剩下了2000多行,取而代之的是一個大模型。

這個大模型,模擬的是人開車習慣。是特斯拉利用上百萬輛特斯拉汽車的行車數據,讓AI進行視覺學習,經過海量的數據學習後,大模型就「學會開車」了。

就像你開車一樣,開車的時候,很多時候你都是下意識的肌肉反應,比如轉向、加速、剎車等等。而AI經過長期大量學習之後,也能用攝像頭看到的圖像,做出和人一樣的思考和控制,不再需要高精地圖、雷射雷達這些軟/硬體的加入。

簡單來說,就是從規則驅動,演變到數據驅動,用無數個老司機的開車的訓練數據集,來訓練出一個AI老司機。

端到端駕駛模式原理

在FSD V12的實際應用過程中,這種智駕路線似乎已經趨於完美,FSD能順滑的完成避開車道內停止的車輛(哪怕壓實線)、能左轉/右轉後變道、能按停止標識剎停、在斑馬線前禮讓行人;路測停著的車突然併線,可以完成躲避並超越突然出現的車輛,在夜間也能完成如此操作。

所以馬斯克就激進地認為,只要數據量足夠大,訓練的時間足夠長,FSD將來就能徹底淘汰人類司機,徹底實現無人駕駛。

從人類科技發展史來看,無論什麼最新的科技,最先的應用,往往都是軍事。

早在2009年谷歌公司的Waymo、特斯拉、Uber、GM Cruise、Aptiv和Intel-Mobileye等公司開始研發智能駕駛技術之前,美國已經開始探索通過智能駕駛機器人來排除IED了。

2018年,美國國防部的領導機構國防創新部門(DIU)說服國會,對軍民兩用和自主技術的加大支持,使私營民用開發商進入國防部採購視野。目前DIU正在推動一項名為「地面遠征自主改造系統」(GEARS)的無人駕駛車輛計劃,從私營承包商中尋求解決方案,並已經成功在悍馬車上試驗成功。

GEARS計劃的短期目標是:在路線清理、爆炸物處理、傷員撤離、補給和偵察援助等高風險行動中,儘量部署無人駕駛車輛;長期目標是:建立大規模無人駕駛車輛部隊,通過有人無人結合的方式,讓每個士兵指揮一個小隊無人車輛和無人機,實現步兵的作戰效能拓展。

毫無疑問,對於FSD的成功,美國軍方一定會很感興趣,不排除將其應用于軍事方面的可能。

比如,坦克能否應用FSD通過大量的坦克駕駛和戰鬥視頻,來學習如何行進和作戰?從而實現真正的作戰無人化?

比如,艦載機起降,不論在哪個擁有航母的國家,都是一個難題,訓練艦載機飛行員非常困難。那麼艦載機能否應用FSD,通過大量起飛和著艦的視覺訓練,實現起飛著艦的自主進行,徹底解放飛行員的雙手雙腳?

再比如,無人戰鬥機是否可以應用FSD,用空戰王牌的視頻資料去訓練它,讓其成為AI王牌?平時在天上長時間戰鬥巡航,如有有外機闖入,自己飛過去攔截。這可比從地面緊急起飛值班戰鬥機要快多了。

FSD的原理其實非常簡單,那麼一旦這種思路在軍事領域擴散,那麼各兵種都會搞出自己的玩法(就像穿越機進戰場之後被開發出無數種玩法一樣),其帶來的結果很可能是革命性的。

但是呢?FSD也不是完美的,應用于軍事,可能還有很長一段路要走。

首先就是其訓練數據的問題。

FSD之所以好用,訓練數據非常重要,但同時,其訓練數據也直接影響FSD的水平。

在特斯拉的應用中,研發人員已經發現,使用田納西州司機訓練出來的大模型,放到紐約就不太合適,因為田納西州地廣人稀,司機駕駛習慣偏向於禮讓,跟車也跟得優哉游哉,絕對不會見縫插針,而紐約呢?街道極其擁擠,日常堵車,你要是再禮讓,保證加塞的車一輛接著一輛,你根本應付不了。

同樣,在美國訓練的FSD大模型,拿到中國來,可能也水土不服。畢竟中國路況實在太複雜了,各種各樣的情況都有,交通規則意識也和美國不同,美國總沒有在國道上曬麥子的吧?總沒有到處亂竄的三蹦子吧?

同樣的道理,軍用FSD要想好用,必須有大量針對性的訓練數據。比如你模擬和俄軍作戰,首先要有與俄軍的訓練數據吧?數據從哪來呢?烏克蘭倒是有,但烏克蘭的作戰方式,和美軍也不一樣啊!

就算你用假想敵中隊來模擬敵軍,但模擬就是模擬的,你永遠不可能以俄軍的現役裝備性能、俄軍的作戰戰術和操典、俄軍的指揮習慣,來逼真的模擬俄軍。所以就算你用模擬俄軍的數據訓練出大模型了,等你真正對上俄軍的時候,可能完全不好使了。

就像當年解放軍打國民黨軍的美械師打習慣了,覺得美械師也不過如此,但到了朝鮮戰場見到真正的美械師,才大吃一驚一樣。

其次是視覺方案的固有缺陷。

FSD使用視覺方案,其基礎是看到的每一幀畫面中,包含多少信息,然後才能根據算法進行識別和決策。

現在的攝像頭,超過1億像素的並不稀罕,但是呢?拍攝視頻時,因為要實現動態拍攝,考慮到緩存速度,視頻像素往往比照片要低得多。以我們見到的非常高清的8K視頻為例,它的像素是多少呢?是7680x4320像素,總計也就3320萬像素。

而人眼呢?正常的人眼像素約為5.76億,遠超一般的攝像頭。

這種差異帶來的結果就是,面對1千米外的目標,人眼可能依稀看見,然後做出反應。但攝像頭啥也看不見,更別說做出決策了。

雖然光學變焦可以解決這一問題,但一旦變焦,視野就小了,難以觀察其他方向情況了。

第三是攝像頭容易被遮擋。

這個很好理解,有時候你過個泥坑,你的倒車影像攝像頭就被泥水糊住了,啥也看不見。

同樣的道理,當軍用車輛用FSD視覺方案進行作戰時,可能遇上泥水、血水、煙霧或者草叢時,可能就不知道該咋辦了。

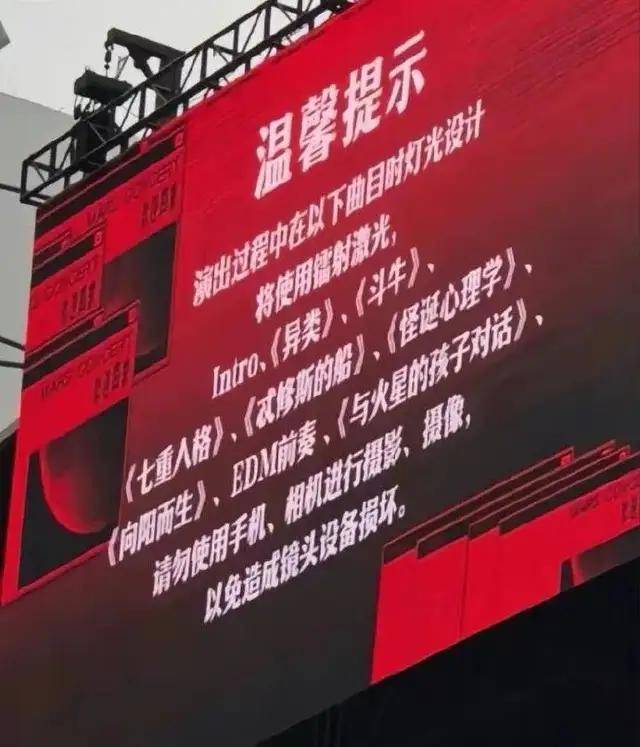

戰機上的攝像頭倒是不容易被污損和遮擋,但問題在於,這玩意實在太脆弱了,敵人一束雷射射過來,攝像頭就被致盲了,嚴重的時候還會燒毀CCD。

不信你隨便去看個演唱會,都能碰上被演唱會雷射表演燒壞手機攝像頭的。

所以,雖然馬斯克的發布會很酷炫,FSD應用于軍事也有很大的前景,但是起碼在目前,FSD的最好出路,還是在只需要看前方百米區域的智能駕駛領域吧,至於軍用,一時半會還是別想了。