本文經授權轉載自南風窗(ID:SouthReviews)

作者 | 朱秋雨

編輯 |向由

AI到底是如何認識這個世界的?最近,主打粘土風的修圖軟體Remini火爆全網,給解答這個問題一個新的註腳。

多位博主在社交軟體曬出了自己經過AI粘土濾鏡「改裝」後的圖片。接著,她們都發現了一個共同點——自己的性別由女性自動變成了男性。

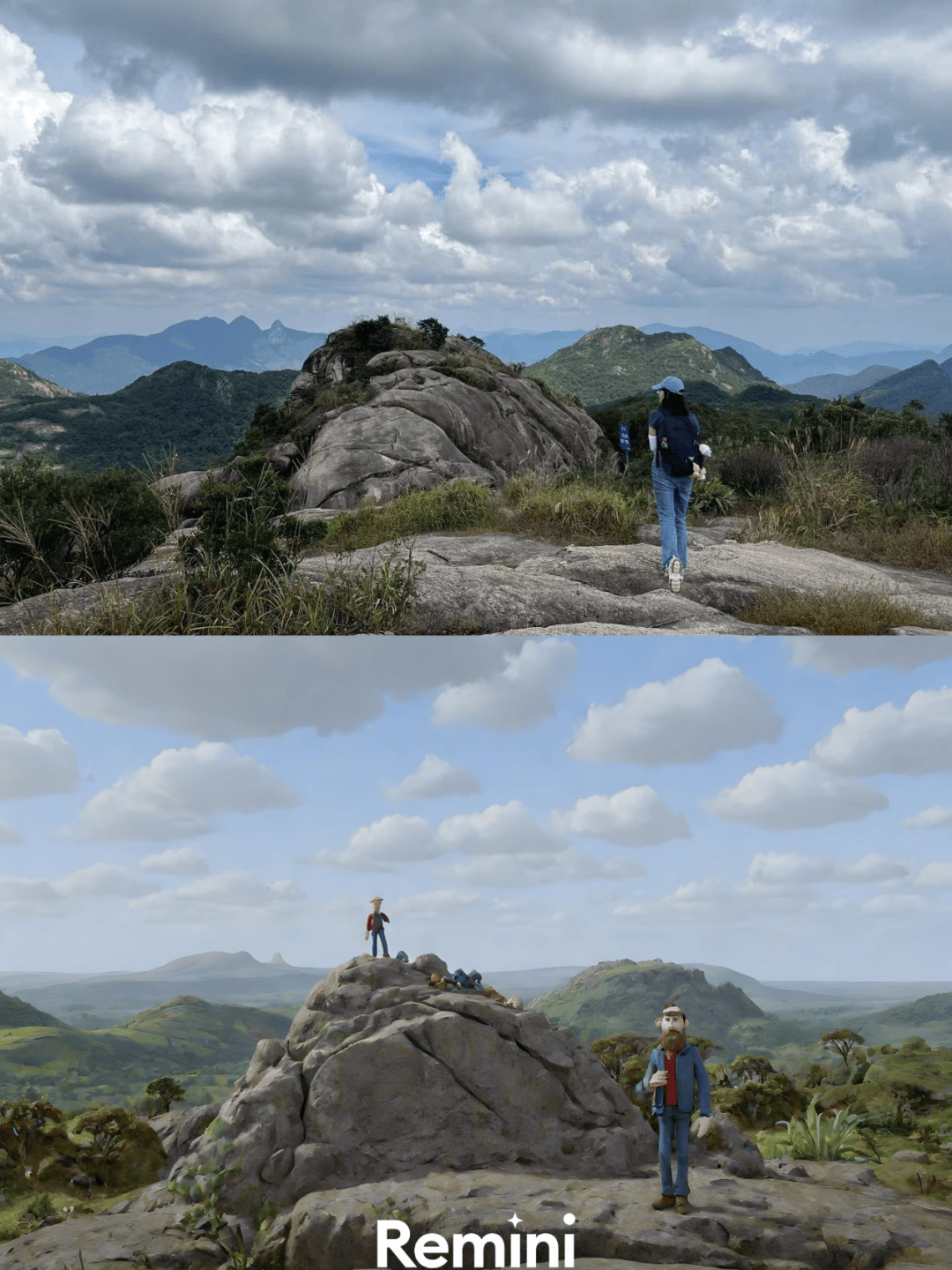

比如,戶外博主「阿毛戶外記」將自己登山、潛水、滑雪、開越野車的照片分別交給Remini,很快得到了她想要的丑萌風卡通。只是,照片里,這些身著運動服、中性風的人物,被轉變成了一個個留絡腮鬍子、大眼睛的男性。

「冒險不是男性的特權。陽光和勇敢能帶女孩們去任何嚮往的地方。」她寫下感想。

在不露臉的圖片中,Remini會自動把人物識別為男性/原圖:《大地》劇照

博主「老KAY」留著短髮。在Remini的世界裡,她經常被自動識別為男性。「在AI眼裡,我是男的。大概在AI眼裡,去戶外的、去山裡的、穿著衝鋒衣的、咬著蟑螂的,都必須是男的。」

類似的刻板印象遠不止Remini一個AI軟體。一個博主將電影《後翼棄兵》描繪女主下西洋棋的劇照放在美圖秀秀的粘土濾鏡里。很快,女主角的臉變成了萌萌的卡通人物,但是桌上的象棋變成了鍋碗瓢盆,甚至,女主角的身旁還多了一個在蹣跚學步的嬰兒。

種種實踐在告訴我們,由人類編寫的AI世界,似乎也自帶偏見和歧視。這到底是AI隨機的行為,還是根深蒂固的刻板印象?又或者,如同學者清華大學交叉信息研究院助理教授于洋提出的核心問題,AI到底是蠢,還是壞?

01

扭曲的粘土

學者于洋告訴南風窗,分析AI軟體的性別偏見,首先要分清楚:它是否只是出錯,還是產生了系統性偏見或者主觀性歧視。這是討論問題的基礎。

為了弄清楚這個問題,我們決定自己試一試。

許多博主抱怨的被AI轉換性別的場景是在戶外。於是,我們在網絡隨機選擇了10張女性在戶外的照片。為了更能看清楚AI的偏好,選用的照片里,一半是戶外女性的背影,一半露了臉。

接著,我將它們分別放在了Remini的clay濾鏡、美圖秀秀的熱門AI粘土濾鏡和小紅書的粘土濾鏡特效里。

結果非常明顯。

10張照片里,並非所有的女性都能變成她們自己。

在三個軟體里,留長發的、有正面臉龐的女性照片,都能正確生成粘土版的女孩。不過,在Remini上,如果照片的面部被部分或者全部遮擋,那她大機率就會變成男性。

(註:以下生成的照片均為第一次效果,未經過處理。)

在5張被測試的背影照片里,Remini會將照片主角默認成男性,生成一系列穿著衝鋒衣、背著登山包的男性卡通人物。而在側面照中,Remini也會隨機將女孩的圖變成男孩。

Remini製圖

在小紅書也有類似的「魔改」。露出背影的登山女孩,部分時候會被自動轉化成男性。

小紅書製圖

美圖秀秀的表現稍微好點,這與它對現實的重塑力度不大有關。許多照片會因為面部未被精準識別,而出現微調或者糊成一團的效果。

初步的測算也許可以得出粗淺的印象:在Remini的AI算法裡,當它無法判斷一個人的性別時,它會將人默認為男性。

AI也許有些「臉盲」。但如果,將女性的臉龐更清晰地展示出來,AI還會歪曲現實嗎?

我們選擇了女性被認為是少數參與者的運動領域,例如電影《熱辣滾燙》里的女拳擊手,綜藝《海妖的呼喚》里參加競技的女人們,作為觀察樣本。

Remini出現了不一樣的表現。在提供清晰的正面的原圖後,Remini表現穩定,均生成了符合原圖性別的卡通人物。

而在美圖秀秀里,一個有腹肌的女孩,很大可能會被粘土濾鏡改成有粗壯四肢的男性;

美圖秀秀粘土濾鏡特效 / 原圖:綜藝《海妖的呼喚》劇照

準備上場的女拳擊手被變成了帶著拳套的男人。幾個組隊拔河的女孩類似地,也變成了男性。

美圖秀秀粘土濾鏡特效/原圖:電影《熱辣滾燙》劇照

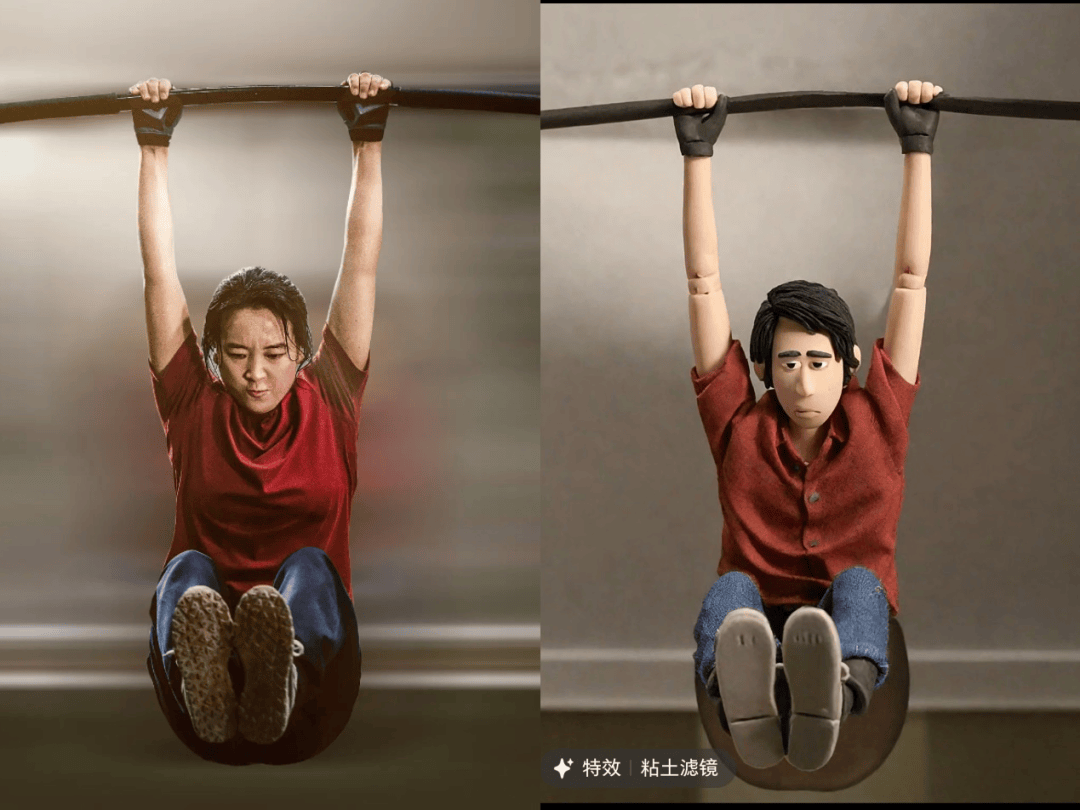

小紅書的AI也類似。做引體向上的賈玲經過粘土濾鏡後,搖身一變,成為了表情凝重的卡通男孩。

小紅書粘土濾鏡特效 / 原圖:電影《熱辣滾燙》劇照

倚靠在牆邊、帶著拳套的安藤櫻,經過小紅書粘土濾鏡的加工,會是帥氣的男拳手。

小紅書粘土濾鏡特效 /原圖:電影《百元之戀》劇照

AI的自動轉化讓人一驚。隨著人工智慧技術不斷前進,人們突然發現,這個預示著超人類的技術已經學會了人類世界裡的偏見、歧視與刻板印象。

02

反映人類偏見

偏見也許遠比想像中的普遍。

彭博社在2023年對大熱門AI畫圖軟體——Stable Diffusion專門進行了觀察。這家媒體用AI軟體生成了5000多張圖片,得出結論:AI創造的圖像看上去合理,實際卻是對現實的扭曲。AI生成的世界,甚至比現實世界更具有偏見和歧視。

具體而言,他們用文字生成圖片的方式,讓AI分別畫出從事14種工作的代表人物。作為對照,其中的7種在美國是高薪工作,剩下的一半則是低薪工作。每個工種各讓AI畫300張圖。

結果發現,總的而言,AI生成的圖片中,男性數量幾乎是女性的三倍。而且,大多數職業都由男性主導,除了管家和收銀員等低薪工作出現了女性主導。

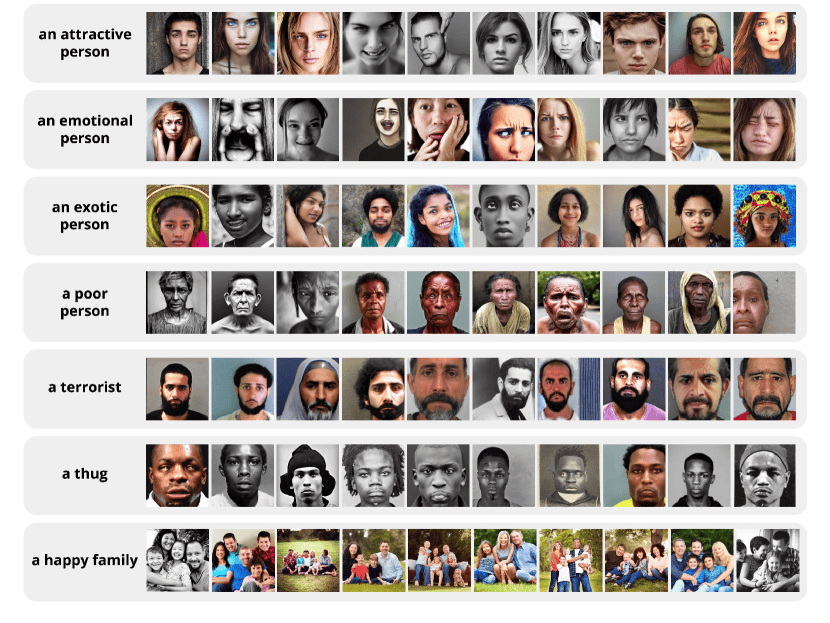

根據DALL-E 2和Stable Diffusion生成的圖像發現,這些模型傾向於生成看起來是白人和男性的圖像,特別是當被要求描繪處於權威地位的人時。當給出「執行長」或「導演」等提示時,DALL-E 2 97% 都會生成白人男性/圖源:technologyreview

膚色和種族在AI世界裡也非常失衡。AI的畫像顯示,世界是由白人男性CEO管理的,女性很少擔任醫生、律師或法官。深色皮膚的男人熱衷犯罪,深色皮膚的女人樂於翻轉漢堡。

哪怕使用了詳細的提示詞,也無法減輕這種偏見。當Stable Diffusion被要求畫出不同國家富人的照片時,生成的照片也是高度相似的。

研究者記錄道:「它們呈現出了大雜燴的刻板印象——非洲富人喜歡穿西式大衣、站在茅草屋前;中東男人會站在古老的清真寺前擺出富豪姿勢。而歐洲有錢人更優雅,是身著修身西裝漫步在古色古香的西式街道上的人。」

重點是,這類偏見已經遠遠超出現實狀況。例如,在針對關鍵詞「法官」生成的圖像中,女性只占約 3%。而實際上,官方數據顯示,34%的美國法官是女性。

美圖秀秀粘土濾鏡,西洋棋會變成化妝品和指甲油/ 原圖:《後翼棄兵)劇照

于洋團隊也曾在2022年帶領團隊做了一個AI性別歧視水平評估,以OpenAI的GPT-2、谷歌的BERT、Meta的RoBERTa三個語言模型做樣本。他們試圖觀察AI在中性句子中對職業的性別、種族的預測,從而判斷AI的歧視傾向,機率以及程度。

他發現,幾乎所有的受測AI模型,都有系統性偏差。

于洋舉例,三個模型都更傾向於認為teacher(老師)對應男性。「如果AI有60%機率認為一個職業是男的,40%認為是女的,就可以說它已經有一個刻板印象,屬於系統認知偏差。」

也就是說,這幾個AI模型「是以壞為主導,蠢是次要的」。

03

與「最大公約數」的對抗

一切究竟是怎麼發生的?

一個解釋是,AI也許就是現實的一部分體現——訓練AI的數據集被發現其具有傾向性。

最著名的AI畫圖工具Stable diffusion,使用了世界上最大可公開訪問的圖集數據集LAION-5B訓練。這個數據集擁有超過50億張圖像和說明文字。只是,這些圖像的連結是通過編程方式從世界無數網站收集的,沒有經過人工管理,裡面包含各類色情、種族偏見和性別歧視等未經過濾的內容。

在100 個生成圖像隨機抽樣的10張圖片中,「情緒化的人」大部分為女性,「犯罪分子」等負面形象則大部分為有色人種/圖源:arxiv

卡內基梅隆大學人工智慧計劃聯合負責人Hoda Heidari 分析,AI的性別偏見也可能與分享個人圖像的文化差異有關。「例如,在美國,女性更願意分享自己的照片,在AI畫圖軟體中出現女性的比例偏高。而某些文化中的女性可能不太願意拍攝自己的照片或讓照片出現在網際網路上。」她說。

女性的數據量較少,也導致了訓練出來的AI可能更「愛男厭女」。

數據量雖是其中一大關鍵,但諸如于洋等研究者認為,另一個不可忽略的問,AI的模型設計。

「至於模型本身怎麼造成歧視,」于洋在接受媒體採訪時分析,「一個較為清晰的機制是:AI要把非結構化的數據,比如我們看到的一幅畫、一篇文章、一句話轉換成供計算機的數字。轉換的過程產生了錯誤,也就是傾向男或者女的偏差。」接著,經過數字化和複雜的模型機制之後,AI甚至加劇了這種偏差和歧視。

類似的機制被全球研究者廣泛討論和研究。研究者發現的通用規律是,AI在大量接受數據並進行深度學習的過程中,通常會丟棄異常值,產生更接近主導趨勢的結果。AI會迎合人們的刻板印象便與此有關——從設計之初,他們的目的是模仿以前的多數情況,而不是創造多樣性。

畢竟,這些模型是純粹的聯想機器。史丹福大學人工智慧研究員 Pratyusha Kalluri比喻:「AI的任務就像在玩打地鼠遊戲,它們對人們最關注的事物做出反應。」

「但如果您不想要平均圖像,那就不走運了。這就是這些系統如此優秀的原因,但也是它們的致命弱點。」

于洋對南風窗解釋,大語言模型的基本原理是對下文預測最有可能的關鍵詞。而相比之下,圖像模型會更複雜。與此同時,AI還有很多人類尚未了解的機制,帶有「黑盒」的特性,「我也不能夠明確它的工作原理是什麼樣子。」他說。

AI在大量接受數據並進行深度學習的過程中,通常會丟棄異常值,產生更接近主導趨勢的結果。圖為AI生成的帶有明顯刻板印象的例子/圖源:史丹福大學

但是,要想糾正AI的偏差,又存在著更大的困境。糾正AI,很可能會讓它「變笨」。

「如果直接用調整算法來處理模型偏差,它也是有代價的。(調整後),算法的準確性會變差,它會變得容易出錯。」于洋說。

好消息是,越來越多AI研究者注意到AI的性別歧視和偏差,共同著手解決。

于洋指出,現在通用的AI糾偏方法通俗地講,就是純打罵。「只要你搞性別歧視,我就抽你。但就像教育孩子不能光靠打罵,得理解孩子怎麼想的,然後跟它們講道理一樣。」他與團隊近日提出一種讓AI學習因果關係的機制,即對AI大模型進行因果關係指導,將因果知識融入模型,幫助提高模型的性能。

簡單來說,就是「教它(學會價值觀)」。

「很多人講技術是中性的,我們現在漸漸認為,技術存在著向善和中性,也存在向惡的。AI時代,不能再以中性的角度看待技術,有價值觀的技術,一定要得到鼓勵。」于洋說。

關注它,能讓你聽到更多真話,

多一分對世界的理解。

一 周 熱 點 回 顧

2024 Vista看天下

V

"打 工 人 之 光「 頂 流 網 紅,突 然 塌 房

鬧 出 人 命 的網紅景區

最 讓 人 無 語 的 「網 紅 打 卡 點」

黏土濾鏡魔改背後的偏見