OpenAI推出「全能模型」GPT-4o,支持語音、視頻、文字實時交互

OpenAI 今天推出了 GPT-4o,這是一種新型的人工智慧模型,你可以通過語音、視頻和文本與它進行實時溝通。

OpenAI 表示,該模型將在未來幾周內上線,並將通過 ChatGPT 應用程式和網頁版免費開放給所有用戶。ChatGPT 的付費訂閱用戶(每月 20 美元起)將能夠提出更多請求。

OpenAI 的 CTO 米拉·穆拉蒂(Mira Murati)主持了 GPT-4o 的發布和現場演示。

值得一提的是,發布會的時間剛好選在谷歌召開 I/O 大會的前一天,谷歌預計將在大會上公布其最新的人工智慧進展。

現有的 GPT-4 雖然提供了類似的功能,為用戶提供了多種與 OpenAI 人工智慧產品交互的方式,但這些功能被放在不同的模型中,導致響應時間更長,計算成本可能也更高。

GPT-4o 現在已經將這些功能合併到一個單一的模型中,穆拉蒂稱之為「全能模型(omnimodel)」。她說,這意味著更快的響應和更平穩的任務轉換。

該公司的演示表明,其結果是一個與 Siri 或 Alexa 非常相似的對話助手,但能夠處理更複雜的提示。

穆拉蒂在談到演示時說:「我們正在展望我們自己和機器之間互動的未來。我們認為,GPT-4o 正在將目前的合作範式轉變為更具未來色彩的合作模式。未來,這種互動將變得更加自然。」

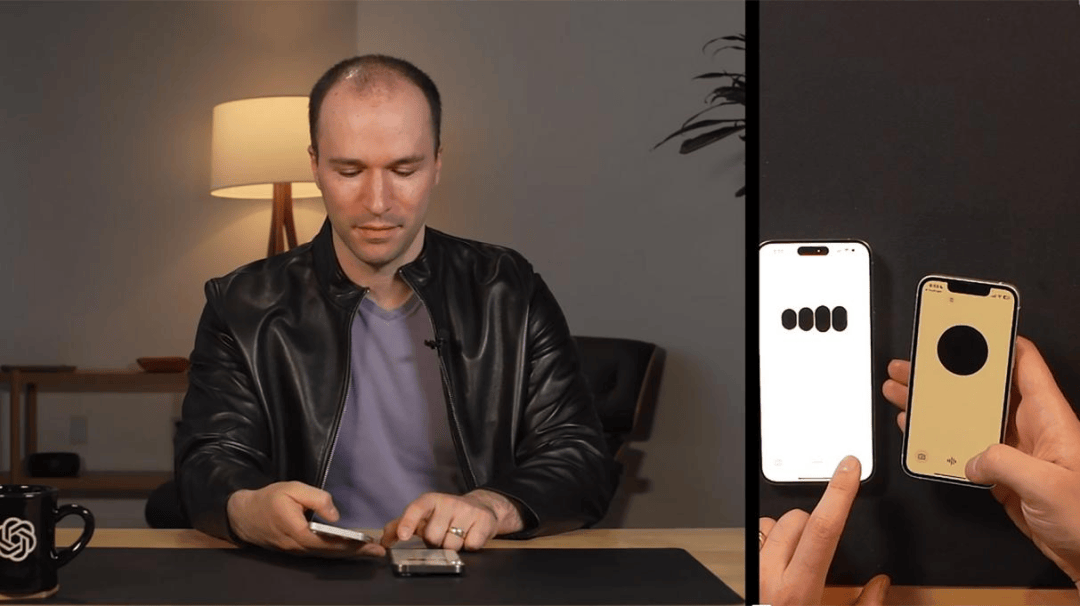

巴雷特·佐夫(Barret Zoph)和馬克·陳(Mark Chen)都是 OpenAI 的研究人員,他們介紹了新模型的一些應用場景。

最令人印象深刻的是它應對實時對話的能力。你可以在模型的回應過程中打斷它,它會停下來,聽你講完並調整回應,就像真人一樣。

OpenAI 也展示了改變模型語調的能力。馬克讓模型在睡前讀一個「關於機器人和愛情」的故事,然後他迅速補充稱,要用更戲劇化的聲音朗讀。

隨即,該模型變得越來越戲劇化,直到穆拉蒂要求它迅速轉向令人信服的機器人聲音(它很擅長這一點)。

在對話過程中,模型會出現一些短暫的停頓,這是它在推理下一步該說什麼,但這並不令人意外。OpenAI 展示了一場節奏非常自然的人類與人工智慧的對話。

(來源:OPENAI)

(來源:OPENAI)

該模型還可以實時推理視覺問題。佐夫用手機拍攝了自己在一張紙上寫代數方程 3x+1=4 的過程,並讓 GPT-4o 提供解題思路。他指示它不要直接給出答案,而是像老師一樣指導他。

該模型友好地說:「第一步是把所有帶未知數 x 的項移到一邊。那麼,你認為我們應該如何處理這個加號?」

穆拉蒂表示,GPT-4o 將存儲用戶與它的交互記錄,這意味著該模型「現在在你的所有對話中都具備一種連續性」。演示的其他亮點包括實時翻譯,檢索模型對話內容的能力,以及實時查詢信息的能力。

正因為是現場演示,我們得以看到了一些小問題和小故障。在談話中,GPT-4o 的聲音可能會不合時宜地響起。在無人要求的情況下,它似乎對其中一位主持人的衣著發表了評論。

但當演示者告訴模型它做錯了時,它處理得很好。它似乎能夠在其他模型尚未有效合併的幾種媒介上快速、有效地做出反應。

此前,OpenAI 的許多最強大的功能,如通過圖像和視頻進行推理,都只限於付費用戶。

GPT-4o 標誌著它們將首次向更廣泛的公眾開放,儘管目前還不清楚免費用戶能與該模型進行多少次互動。

OpenAI 表示,付費用戶的消息限制「仍然是免費用戶限制的五倍」。

支持:Ren

運營/排版:何晨龍