作者丨邱曉芬

編輯丨蘇建勛

7月4日-7日,世界人工智慧大會(下稱WAIC)在上海世博展館開啟。而算力,作為AI發展的剛需要素,讓展館中的晶片企業成為關注焦點。

如果說,去年的WAIC上,行業里GPU只有英偉達一個獨苗可以選擇,情況在今年有了巨大的變化。

2024年的WAIC,分為H1、H2、H3三個館。據《智能湧現》作者觀察,其中,H2館基本有一半的廠商都是和智算中心、晶片有關的廠商,大玩家也基本聚齊:華為、百度崑崙芯、天數智芯、摩爾線程、算能、中科曙光、燧原等等。

不過,由於晶片還是一個相對敏感的話題,冒頭的廠商們,展示方式上還是略顯收斂。

WAIC上的晶片展台擠滿了人 作者拍攝

多位晶片廠商人士告訴《智能湧現》,他們最新的晶片產品並不敢拿出來展示,也不打算正式發布。在展示方式上,大家形成了心照不宣的默契,並不願意直接呈現晶片本身——而是直接呈現裝好晶片的伺服器,或者是以合作夥伴的落地案例來展現。

WAIC作為人工智慧行業的一個集中觀察窗口,從這裡我們可以窺見2024年的國產算力發展趨勢。隨著大模型逐漸往兩派分化——一派追逐務實的商業化落地,另外一派是技術理想派,還在持續進發追求高參數量。

有趣的是,同樣的趨勢也出現在上游的算力端。目前,國內的晶片廠商也呈現了策略上的兩極分化,一派繼續往萬卡、萬P進發,另一派則更關注大模型在各行各業的落地訴求,推理晶片進入爆發前夜。

推理晶片大爆發

在WAIC上,有多家晶片廠商稱其推理晶片銷售量大幅提升。比如,天數智芯、燧原的工作人員都告訴《智能湧現》,他們的推理晶片產品去年以來都有了數萬片的出貨,出貨渠道包括智算中心等等。

百度的一位工作人員也表示,崑崙芯過去兩代產品也都是推理卡,目前來自百度和外部渠道的出貨量大概是1:1,「至今累計出貨量也有三五萬片左右」。

不過,前述這些晶片廠商的推理卡,還是面向更大的模型參數,主打雲端,當前也有不少晶片廠商瞄準了端側的機會,主打用一顆小晶片跑端側大模型推理。

晶片廠商「愛芯元智」的一位工作人員告訴《智能湧現》,他們的某顆小晶片雖然只能運行2B參數量的模型,但優點是可以進行本地端側運行,保證了隱私性,成本上也很可觀。據其介紹,目前這顆晶片能廣泛用於監控攝像頭等IoT設備上,已是「供不應求的狀態」。

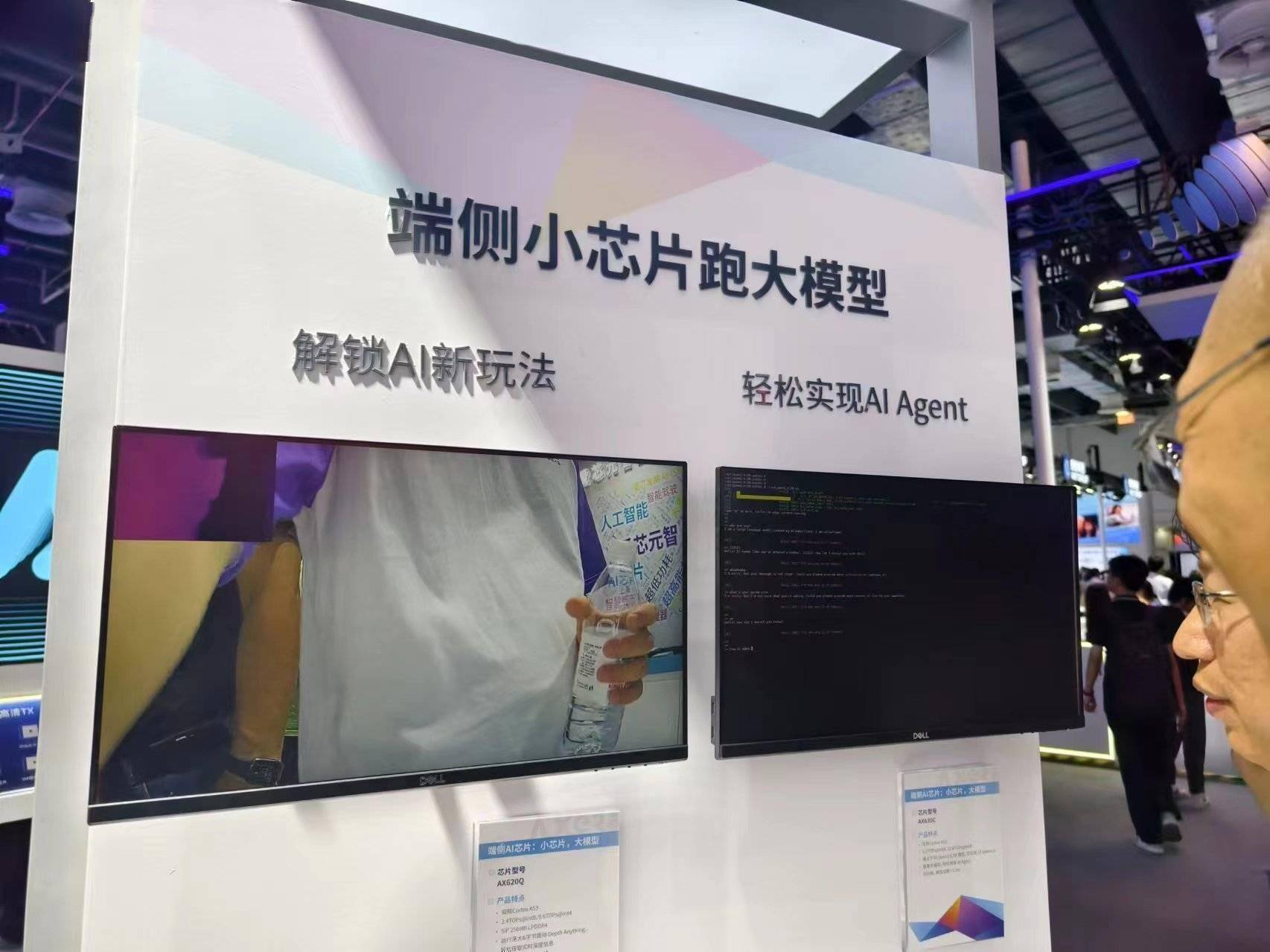

端側小晶片展台火熱 作者拍攝

推理晶片的大爆發,是一個市場和競爭綜合作用的結果。

隨著主流大模型逐漸推進開源、以及大模型廠商們今年為了搶奪市場瘋狂降價,大模型逐漸在各行各業落地。推理正是一個「用」大模型的過程,需要大量的推理晶片的支撐。和訓練場景不一樣的是,推理晶片面向的是各行各業,眼前是星辰大海。

而更重要的是,這也是英偉達晶片沒有滲透到的廣泛市場。在此前,行業內一般採用英偉達的4090、L20這些產品來跑大模型推理,不過英偉達這類產品的缺點也相當明顯。

比如,英偉達的4090其實是消費級顯卡,英偉達官方並不允許其運用於大模型推理,目前也面臨著禁運的情況。而更關鍵的是,英偉達這些晶片由於並非針對推理場景制定,存在著功耗過大、內存不夠等情況,難以滿足訴求。

而前述那些「賣爆」的產品,也正是基於英偉達的種種阿喀琉斯之踵而切入。4090、L20,基本是這些國產推理卡的直接對標對象。

一名天數智芯的工作人員稱,他們推出的「大模型推理16卡伺服器」,16卡伺服器的單機顯存達到512GB,單卡成本和4090差不多的情況下,功耗只有其1/3,並且,「供應穩定持續有貨」,目前已經打入了某大模型廠商供應鏈。

除了傳統的晶片廠商之外,《智能湧現》發現,目前也有中興在內的新玩家進入推理晶片市場,以及出現了全新的商業模式。

「如今已到了推理卡爆發的前夜」,一位晶片廠商人士感慨道。

從千卡躍進萬卡,這是少數人的遊戲

一面是推理晶片爆發,另一面是,國產晶片廠商在還在堅持追逐更高的算力,國產算力集群逐漸從過去的千卡規模,向萬卡規模進發。在WAIC上,摩爾線程也發布了國內首個萬卡規模的智算集群解決方案「夸娥」(KUAE)。

目前,超萬卡集群已經成為頭部大模型廠商預訓練的標配。在海外,Open AI、谷歌、Meta都已經有了萬卡集群。其中,Open AI更是擁有五萬卡以上的規模。

《智能湧現》了解到,目前國內只有位元組跳動等極少數企業擁有萬卡規模,都是英偉達的產品。另外,華為、摩爾線程也是萬卡規模的擁簇者,不過都是用各自的晶片搭建而成。

萬卡集群是針對萬億參數級別的大模型而設計,目前行業對此,有的持樂觀態度,有的還在觀望、猶豫。

在WAIC上,有不少晶片廠商人士向《智能湧現》提出了自己的顧慮——萬卡智算中心的投入動輒幾十億,而萬億參數的大模型目前應用場景有限,商業落地的可行性還要再繼續考察。這些廠商目前更關注幾百卡、幾千卡的集群規模優化。

另外,從千卡到萬卡級別,不僅僅是GPU數量多個零那麼簡單,而是在軟體層面提出了更高的要求。

接踵而來的難題是:萬卡集群如何搭建超大規模的組網互聯繫統?一萬張GPU的計算效率如何最大化?大模型訓練時如何保證高穩定性和長期穩定性?萬卡集群不僅僅是硬體投入翻十倍那麼簡單,還有更多軟體上的功夫要做。

不過,堅定的萬卡集群擁簇者們,則對於這一切持樂觀態度。

摩爾線程創始人張建中表示,一方面,自從2020年提出的大模型Scaling Law在未來將會持續奏效——通過算力、算法、數據的深度融合與經驗積累,實現模型性能的飛躍,這種「暴力美學」將繼續影響未來大模型的趨勢。

另一方面,Transformer架構雖然是當前主流,但新興架構(如Mamba、RWKV、RetNet)還在不斷刷新計算效率。架構的創新,都會轉化為對更高性能計算資源的需求。

目前,萬卡集群畢竟還是少數人的遊戲,背後考驗的是,晶片廠商們的金錢實力、技術能力、商業判斷等等。

end

end