Intel執行長Pat Gelsinger在Vision 24大會宣布與合作夥伴共建AI開放平台,並展示RAG技術,讓現有大型語言模型能夠搭配具有新資訊的資料庫,快速更新AI的「認知」。

目前使用大型語言模型(Large Language Model,以下簡稱LLM)的一大問題,就是LLM僅擁有的訓練當下所輸入的資訊,而對於訓練之後所發生的事件一無所知。舉例來說,使用截至2023年的數據所訓練的LLM,可能很擅長回答2022年的資訊,但若詢問2024年的資訊,可能就會出現錯誤甚至得到「無法回答」的結果。

然而加入新數據並重新訓練LLM並不是件簡單的事,過程需要花費許多時間與電力(意味著高額電費或是伺服器租賃費用),若以每月或是每周的頻率重新訓練,將衍生沉重的成本負擔。

而檢索增強生成(Retrieval Augmented Generation,以下簡稱RAG)則是能在現有LLM之上「插件」包含有新數據、文件、文件的資料庫,讓LLM能夠自動從資料庫尋找資訊,簡化加入新數據的工作流程。

另一方面Intel也攜手Anyscale、DataStax、Domino、Hugging Face、KX Systems、MariaDB、MinIO、Qdrant、RedHat、Redis、SAP、SAS、VMware、Yellowbrick和Zilliz等合作夥伴,宣布創建適合企業AI的開放平台,協助企業快速導入LLM與各種AI解決方案。

企業AI開放平台也能與RAG相輔相成,企業能夠下載開放的LLM搭配私有資料庫,並集成為能夠回答包含私有資訊的聊天機器人,實現效益更高的部署便利性、最佳性能和價值,並且落實在本地端進行AI推論以降低安全風險,強化企業的生成式AI應用。

檢索增強生成(Retrieval Augmented Generation,RAG)能夠讓現有LLM「讀取」新資料庫的資訊,達到快速追加新數據的效果。

Intel攜手眾多合作夥伴創建適合企業AI的開放平台。

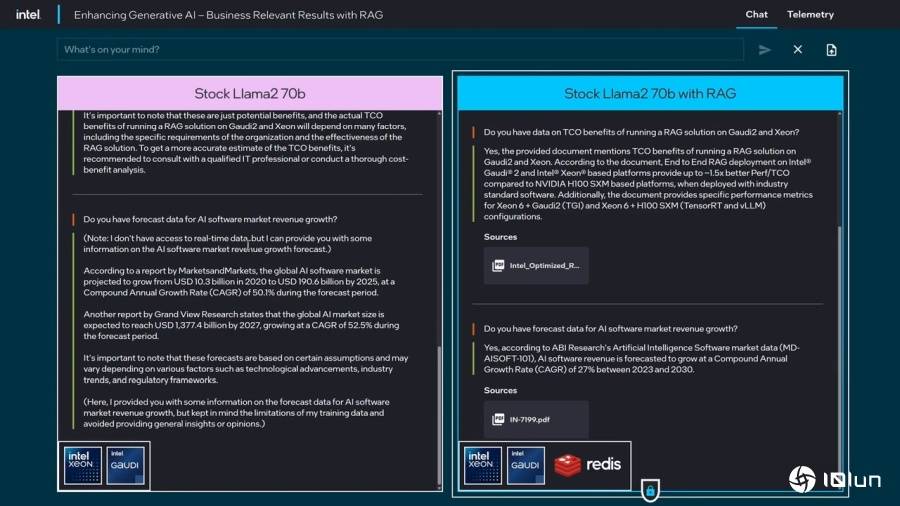

Pat Gelsinger也在Vision 24大會演說上進行RAG的實際展示,展現RAG能夠協助用戶爬梳資訊,由資料庫中的文件文件找出具有參考價值的回答。

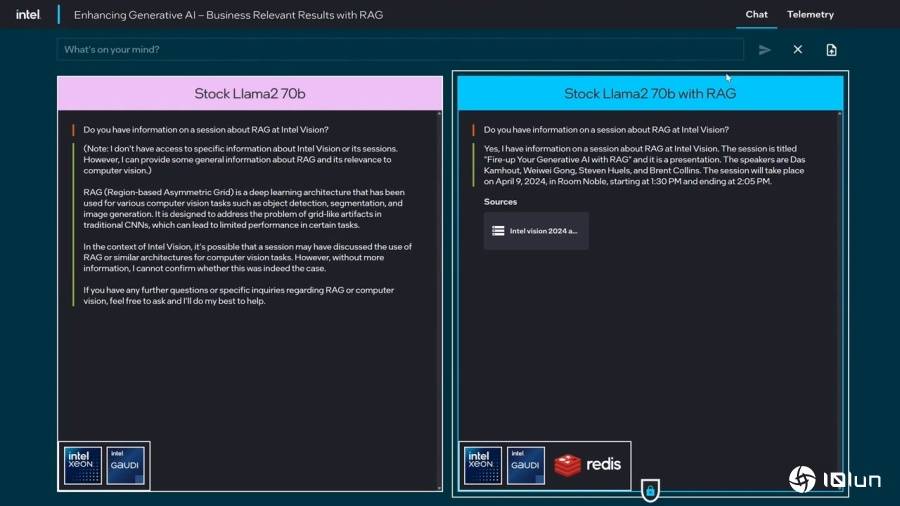

Vision 24大會演說進行的RAG實際展示,展示平台為執行於Gaudi 2加速器上的Llama 2 70B模型。(可參考重播視頻的3:30開始段落)

當被詢問到Vision 24大會中RAG段落的資訊時,左方的純Llama 2 70B模型回應不知道資訊,然後列出RAG的解釋。右方的Llama 2 70B模型搭配RAG則能在資料庫中找到演說數據,並列出數據源的參考文件。

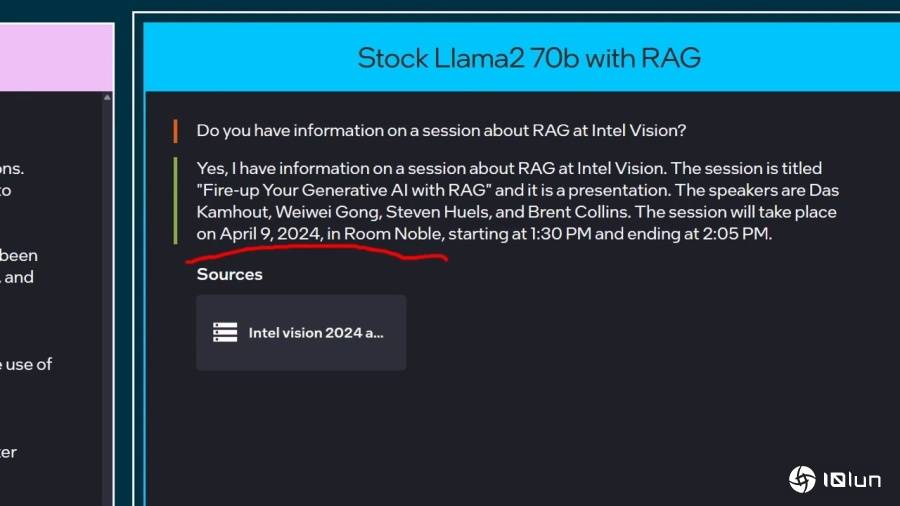

將畫面放大看,搭配RAG的情況下能夠回答演說的日期、時間、地點等資訊。

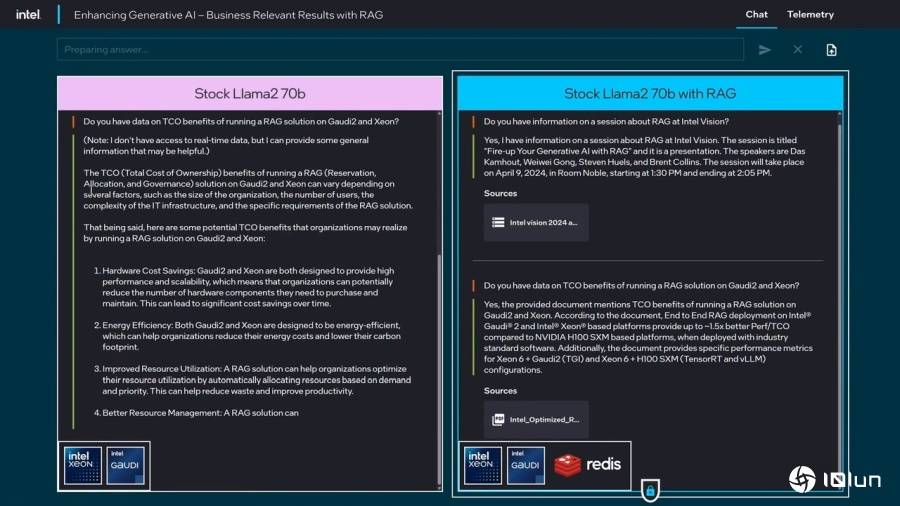

接下來詢問RAG搭配Gaudi 2加速器與Xeon處理器能帶來的TCO效益,純Llama 2 70B模型回應相當冗長,但資訊並不是十分實用。Pat Gelsinger開玩笑說跟他的一位叔叔一樣,講了半天但是沒有重點。

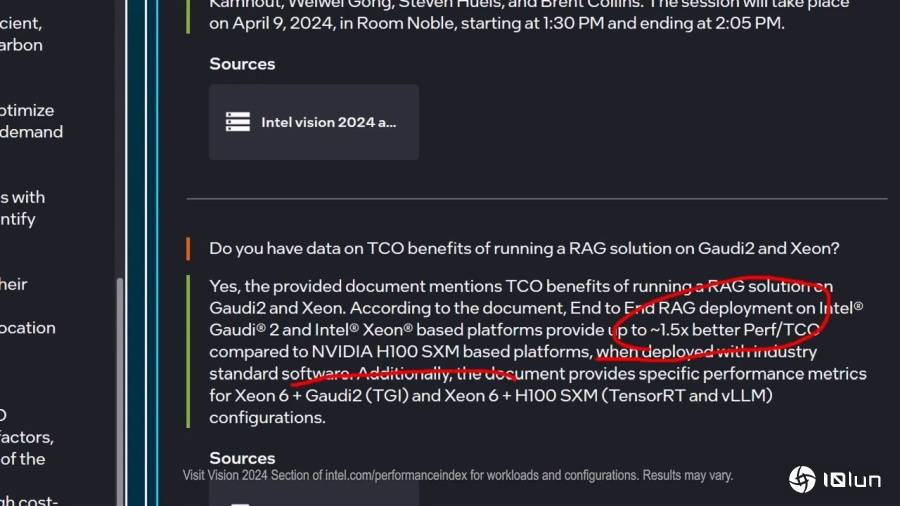

搭配RAG則是清楚回應能夠提供1.5倍相對於NVIDIA H100平台的TCO優勢。

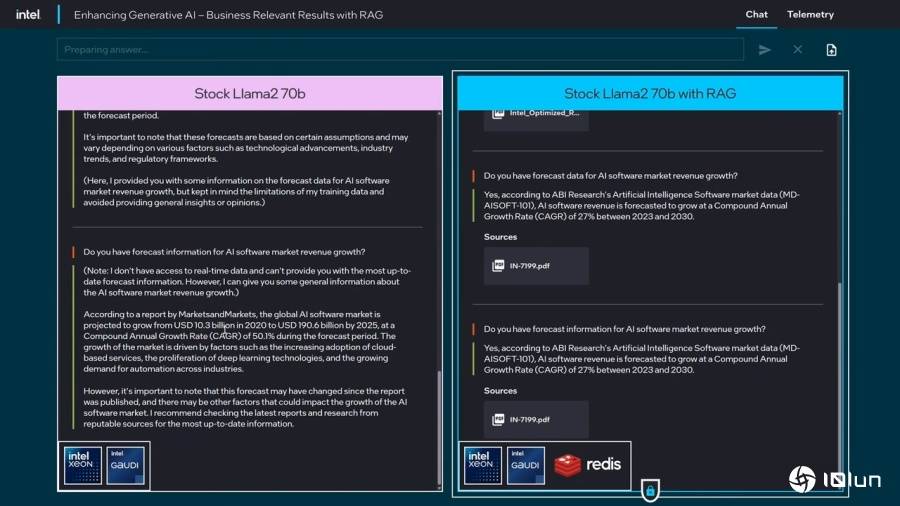

接下才測試輸入提示詞對回答造成的影響,先輸入你有AI軟體市場增長的預估數據嗎(Do you have forecast data for AI software market revenue growth?)。

接下來將問題原文的數據(data)改為資訊(inforamtion),純Llama 2 70B模型的2次回答南轅北轍,而搭配RAG則回答相同,能夠降低不同提示詞所造成的回答偏差。

有興趣了解更多資訊的讀者,可以到Intel官方網站觀看Vision 24大會演說的精華片段,以及更多技術展示。