作者 | 陳大鑫

剛才,有兩個年輕人問我,陳老師,發生腎摸事了?

我說腫麼了?

塔燜啪的一下發來了一張截圖,很快噢!

嗷!源賴氏佐田,有兩個AI人,一個24歲,一個29歲,一個發過4篇頂會,一個發過9篇頂會。

塔燜問我 NeurIPS 2020還兩個星期就要召開啦,可是收錄的1900篇論文, 塔燜怎麼讀都讀不完了~

我說這個問題嫩們算是問「對」人了,因為陳老師我 作為渾元形意AI掌門人億篇頂會都沒發過,但是我之前已經「教」過大家了:

AI科技評論給大家提供了兩個NeurIPS 2020論文閱讀的便利。

1、閱讀大牛的論文:

見「NeurIPS 2020論文接收大排行!谷歌169篇第一、史丹福第二、清華國內第一 」一文。

在這篇文章中,AI科技評論列舉了AI學術大牛如深度學習三巨頭、周志華、李飛飛等人的論文,大牛的團隊出品的論文,質量平均而言肯定有很大保證的。

2、按主題分門別類的閱讀:

這是顯而易見的選擇,也是大家正在做的事情,AI科技為此也為大家整理了一份超詳細的分門別類指南,見NeurIPS 今年共收錄1900篇論文,我該怎麼閱讀? 一文。

他們說我這個不行,我說我這個行,他們說他們甚至懶得讀論文的摘要,我說好吧,那嫩們要不要試試看我的閃電閱讀法:

好吧,閃電閱讀法可能有些難學,今天陳老師給大家介紹一個刷 NeurIPS論文列表的神器,幫助大家高效地有選擇性的閱讀。

這就是Paper Digest團隊給大家提供的 「One sentence highlight for every

NeurIPS-2020 Paper」, 又名為: Paper Digest: NeurIPS 2020 Highlights

網址:https://www.paperdigest.org/2020/11/neurips-2020-highlights/

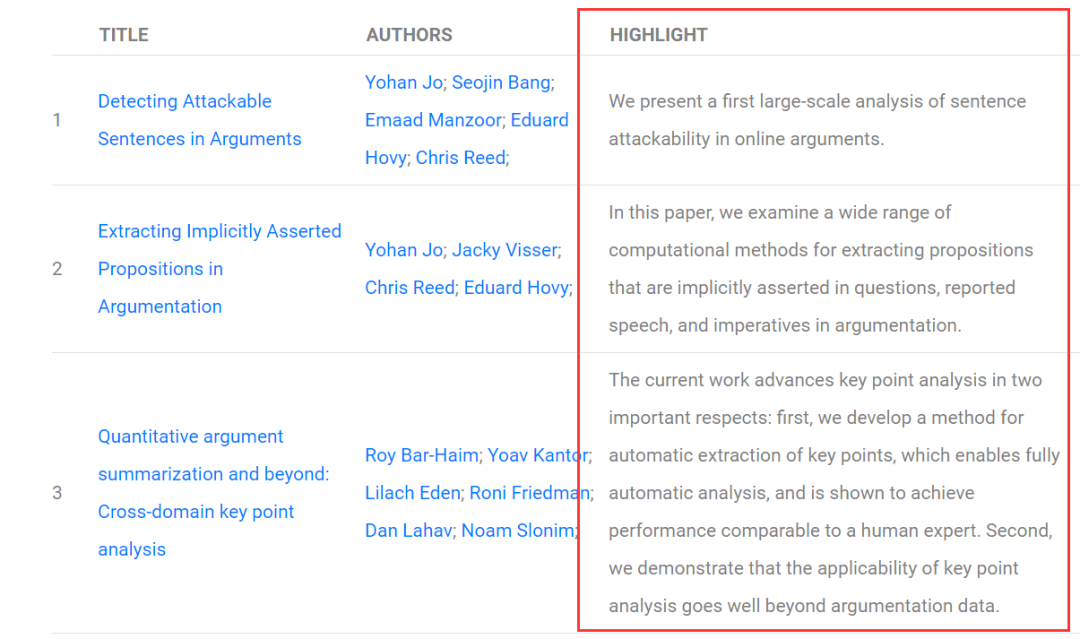

在這個網站上,他們用AI為每一篇論文自動生成一句話超短摘要(Highlight),以此幫助大家更快地了解到每篇論文的最核心的idea和貢獻,從而更快篩選出自己感興趣的論文。

圖中 Highlight一列就是每篇文章的重點:

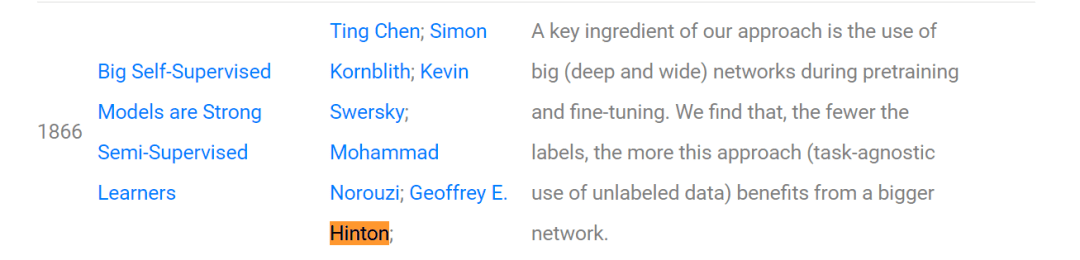

我們不妨來看一下這個網站對Hinton團隊在NeurIPS 2020上發表的論文《Big Self-Supervised Models are Strong Semi-Supervised Learners》生成了什麼樣的摘要:

A key ingredient of our approach is the use of big (deep and wide) networks during pretraining and fine-tuning. We find that, the fewer the labels, the more this approach (task-agnostic use of unlabeled data) benefits from a bigger network.

翻譯下來大概是:

我們方法的一個關鍵因素是在預訓練和微調期間使用大(深和寬)網絡。我們發現,標籤越少,這種方法(對未標記數據的任務無關性使用)從更大的網絡中獲益越多。

而碰巧的是AI科技評論前些天寫了一篇文章對Hinton團隊這篇論文做了介紹:Hinton新作!越大的自監督模型,半監督學習需要的標籤越少 , 大家可以評判一下這個AI生成的摘要效果到底如何?

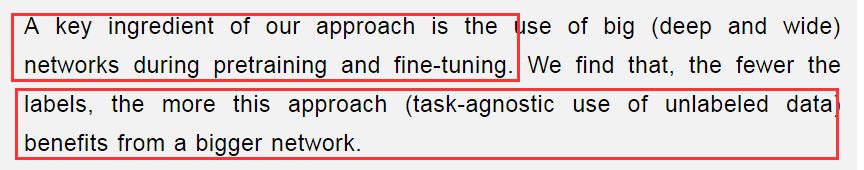

另外有眼尖心細的朋友發現了:陳老師,這並不是一句話摘要吧?上面明明是兩句話好吧?

話落,又給我發了張截圖:

我啪的一下就站起來了!看來是有Bear而來啊......

AI不講武德,說好的一句話怎麼變成兩句了呢?......

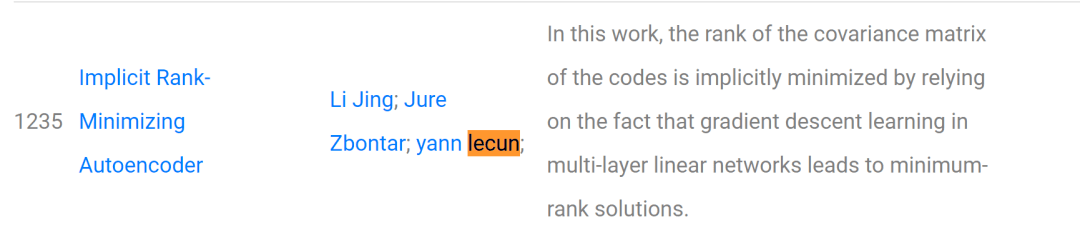

我接著又放出了Lecun團隊論文的一句話摘要:

In this work, the rank of the covariance matrix of the codes is implicitly minimized by relying on the fact that gradient descent learning in multi-layer linear networks leads to minimum-rank solutions.

我說嫩們看看!這是不是只有一句話?

本文利用多層線性網絡中的梯度下降學習導致最小秩解的事實,隱式地最小化了碼的協方差矩陣的秩。

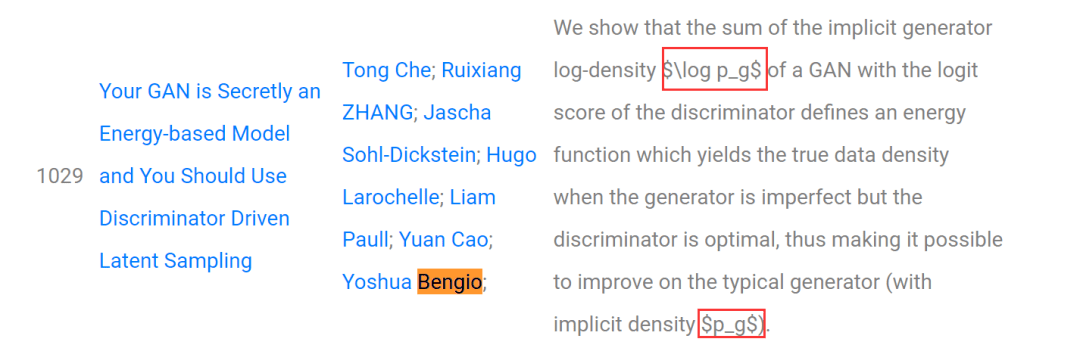

這時,來了一位200多斤的「大理石」,他說他找到了Bengio老師論文的一句話摘要:

他問我$log p_g$是什麼意思?他說這不行,妨礙他閱讀了。

我說婷婷!年輕人不要太較真,這好嗎?這不好,你這樣還怎麼讓AI去「騙」,去偷襲1900篇的老論文......

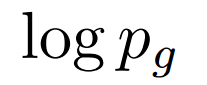

再說這是小學二年級就該學過的指數表達符號啊:

這是問題嗎?這不是...

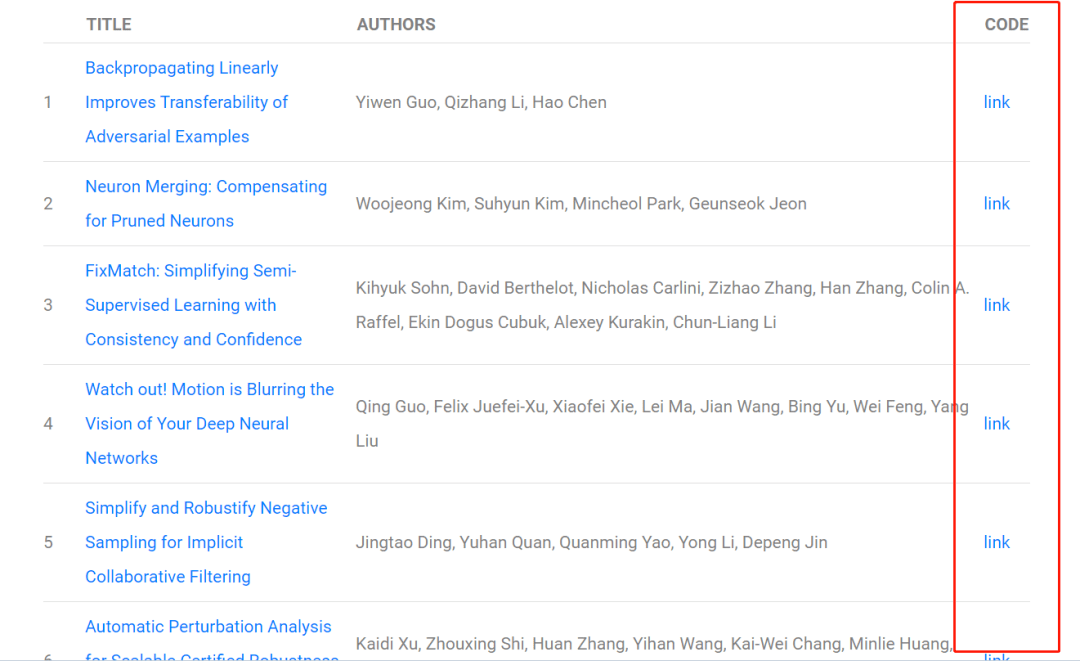

最後,除了一句話摘要外,本網站還能查到有150多篇已經有開原始碼/數據集的論文:

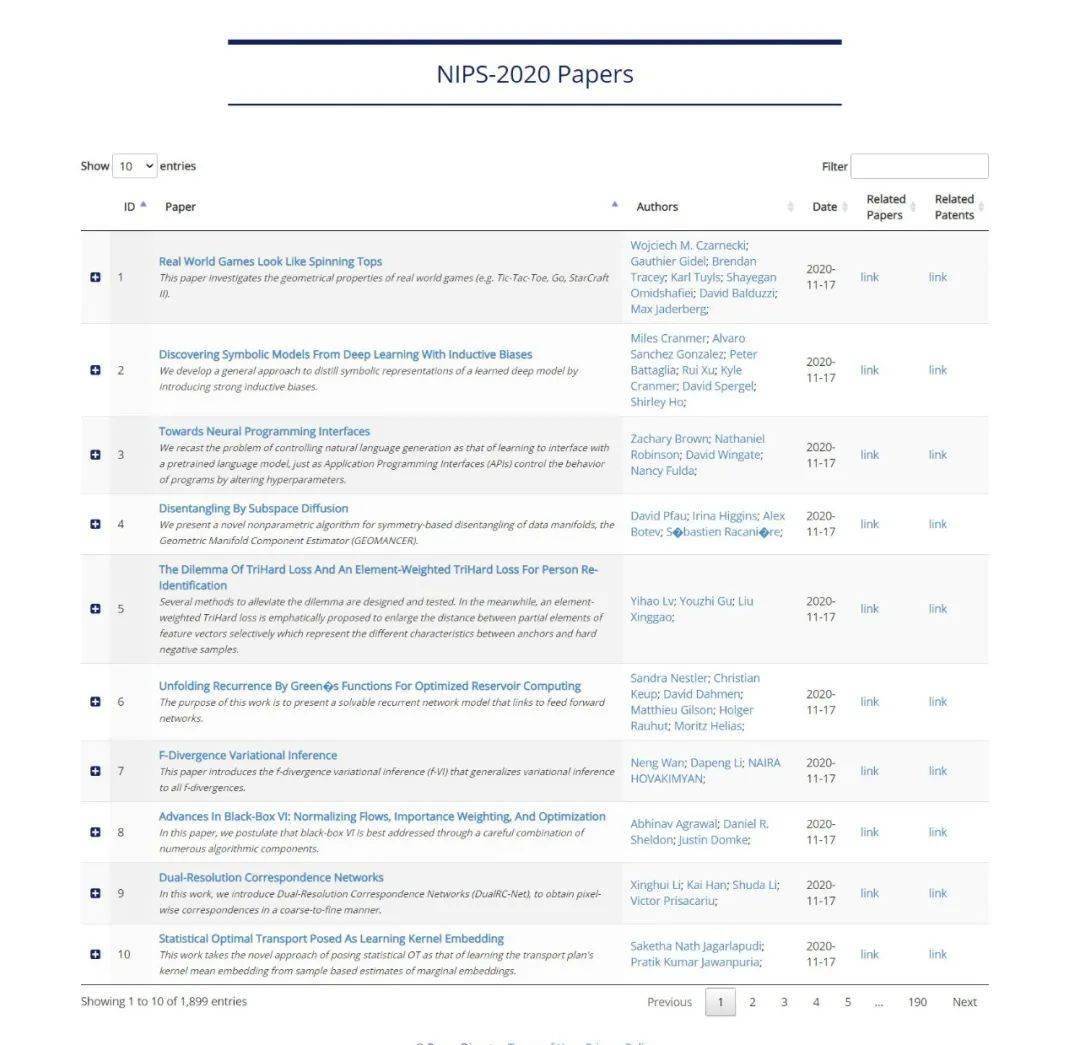

而以下網站則是以每頁十篇論文的方式更為方便地為大家展示了論文。

https://www.paperdigest.org/topic/?topic=nips&year=2020

1900篇論文,我勸各位AI人耗子尾汁,好好反思,以後不要再犯這樣的聰明,小聰明…......

愛(AI)要以和為貴,要講武德,不要只講數量,要講質量!

不要搞窩裡斗,不要內卷,謝謝朋友們!

參考「文獻」:

https://www.paperdigest.org/2020/11/neurips-2020-highlights/

https://www.paperdigest.org/2020/11/neurips-2020-papers-with-code-data/